| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |

- Unsupervised learning

- Explainable AI

- 설명가능한

- 코딩 테스트

- Class activation map

- 설명가능한 인공지능

- xai

- Artificial Intelligence

- 메타러닝

- Interpretability

- grad-cam

- 코딩테스트

- 기계학습

- 딥러닝

- 백준

- coding test

- 인공지능

- AI

- GAN

- Cam

- Machine Learning

- Score-CAM

- Deep learning

- 머신러닝

- cs231n

- keras

- meta-learning

- 시계열 분석

- python

- SmoothGrad

- Today

- Total

목록분류 전체보기 (125)

iMTE

이전 포스팅에서 정상성 시계열은 AR과 MA로 나타낼 수 있음을 설명하였다. 이번 포스팅에는 AR, MA 모형을 각각 설명하고 이 두개가 합친 ARMA 모형에 대해서 소개하고자한다. 먼저, AR의 기본적인 형태는 다음과 같다. Zt=ϕ1Zt−1+at 위 식에서 ϕ는 정상성 조건을 만족시키며, at는 평균이 0, 분산이 σ2을 갖는 white noise 이다. 위 식은 시차 1의 과거 값에 영향을 받음으로, AR(1) 모형이라고 부른다. 만약 시차 p인 AR(p) 모형은 다음과 같이 표현된다. Zt=ϕ1Zt−1+ϕ2Zt−2+...+ϕpZt−p+at 위 식에서 ϕ는 정상성 조건을 만족시킨다. 간단..

보통 시계열분석에서 stationary 시계열을 다루며, non-stationary 시계열은 여러 변환 (예, differentiation) 들을 통해서 정상적인 시계열으로 바꾼 이후에 분석을 한다. 1) 강정상성, strong stationary (Z1,...,Zm)과 (Z1+k,...,Zm+k) (k>1)이 동일한 결합확률분포를 가질 때 strong stationry 시계열이라고 한다. 2) 위의 조건을 만족할 경우 다음 성질을 갖는다. (1) E[Zt]=μ,t≥1 (2) Var[Zt]=σ2=γ(0),t≥1 (3) Cov[Zt,Zt−k]=Cov[Zt+k,Zt]=γ(k),t≥1 (자기공분..

모델을 만들어 낸 다음에, 모델의 예측 성능을 평가하기 위해서는 예측성능 척도가 필요하다. 먼저, error는 다음과 같이 정의가 된다. et,1=Xt+1−ft,1 위 식에서, Xt+1은 t+1 시점의 실제 값이고, ft,1은 t 시점에서 모델에 의해 예측된 t+1 값을 의미한다. 만약 여러개의 관측치에 대한 예측 오차를 계산할 때, 4개의 예측 성능 척도가 사용된다. 1) Mean squared error (MSE) 2) Root mean squared error (RMSE) 3) Mean absolute deviation (MAD) 4) Mean absolute percent error (MAPE) 위 척도는 다음과 같은 수식으로 나타낼 수 있다. $MSE=\..

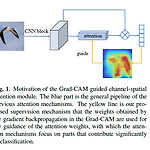

Grad-CAM Guided Channel-spatial Attention Module for Fine-grained Visual Classification 내용 정리 [XAI-13]

Grad-CAM Guided Channel-spatial Attention Module for Fine-grained Visual Classification 내용 정리 [XAI-13]

논문 제목 : Grad-CAM Guided Channel-spatial Attention Module for Fine-grained Visual Classification 논문 주소 : https://arxiv.org/abs/2101.09666 Grad-CAM guided channel-spatial attention module for fine-grained visual classification Fine-grained visual classification (FGVC) is becoming an important research field, due to its wide applications and the rapid development of computer vision technologies. Th..

Ablation-CAM: Visual Explanations for Deep Convolutional Network Via Gradient-free Localization [XAI-12]

Ablation-CAM: Visual Explanations for Deep Convolutional Network Via Gradient-free Localization [XAI-12]

논문 제목 : Ablation-CAM: Visual Explanations for Deep Convolutional Network Via Gradient-free Localization 논문 주소 : https://openaccess.thecvf.com/content_WACV_2020/html/Desai_Ablation-CAM_Visual_Explanations_for_Deep_Convolutional_Network_via_Gradient-free_Localization_WACV_2020_paper.html WACV 2020 Open Access Repository Ablation-CAM: Visual Explanations for Deep Convolutional Network via Gradient-..

Group-CAM: Group Score-Weighted Visual Explanations for Deep Convolutional Networks 내용 정리 [XAI-11]

Group-CAM: Group Score-Weighted Visual Explanations for Deep Convolutional Networks 내용 정리 [XAI-11]

논문 제목 : Group-CAM: Group Score-Weighted Visual Explanations for Deep Convolutional Networks 논문 주소 : https://arxiv.org/abs/2103.13859 Group-CAM: Group Score-Weighted Visual Explanations for Deep Convolutional Networks In this paper, we propose an efficient saliency map generation method, called Group score-weighted Class Activation Mapping (Group-CAM), which adopts the "split-transform-merge" str..

SS-CAM: Smoothed Score-CAM for Sharper Visual Feature Localization 내용 정리 [XAI-10]

SS-CAM: Smoothed Score-CAM for Sharper Visual Feature Localization 내용 정리 [XAI-10]

논문 제목 : SS-CAM: Smoothed Score-CAM for Sharper Visual Feature Localization 논문 주소 : https://arxiv.org/abs/2006.14255 SS-CAM: Smoothed Score-CAM for Sharper Visual Feature Localization Interpretation of the underlying mechanisms of Deep Convolutional Neural Networks has become an important aspect of research in the field of deep learning due to their applications in high-risk environments. To expl..

Score-CAM : Score-weighted visual explanations for convolutional neural networks [XAI-9]

Score-CAM : Score-weighted visual explanations for convolutional neural networks [XAI-9]

논문 제목 : Score-CAM : Score-weighted visual explanations for convolutional neural networks 논문 주소 : https://openaccess.thecvf.com/content_CVPRW_2020/html/w1/Wang_Score-CAM_Score-Weighted_Visual_Explanations_for_Convolutional_Neural_Networks_CVPRW_2020_paper.html CVPR 2020 Open Access Repository Haofan Wang, Zifan Wang, Mengnan Du, Fan Yang, Zijian Zhang, Sirui Ding, Piotr Mardziel, Xia Hu; Proceedi..

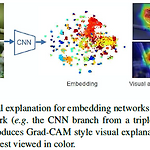

Adapting Grad-CAM for Embedding Networks 내용정리 [XAI-8]

Adapting Grad-CAM for Embedding Networks 내용정리 [XAI-8]

논문 제목 : Adapting Grad-CAM for Embedding Networks 논문 주소 : https://openaccess.thecvf.com/content_WACV_2020/html/Chen_Adapting_Grad-CAM_for_Embedding_Networks_WACV_2020_paper.html WACV 2020 Open Access Repository Lei Chen, Jianhui Chen, Hossein Hajimirsadeghi, Greg Mori; Proceedings of the IEEE/CVF Winter Conference on Applications of Computer Vision (WACV), 2020, pp. 2794-2803 The gradient-weighte..

Interpretable and fine-grained visual explanations for CNNs 내용 정리 [XAI-7]

Interpretable and fine-grained visual explanations for CNNs 내용 정리 [XAI-7]

논문 제목 : Interpretable and fine-grained visual explanations for CNNs 논문 주소 : openaccess.thecvf.com/content_CVPR_2019/html/Wagner_Interpretable_and_Fine-Grained_Visual_Explanations_for_Convolutional_Neural_Networks_CVPR_2019_paper.html CVPR 2019 Open Access Repository Interpretable and Fine-Grained Visual Explanations for Convolutional Neural Networks Jorg Wagner, Jan Mathias Kohler, Tobias Gindel..